Oobabooga

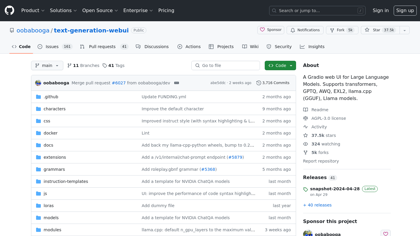

GitHub - oobabooga/text-generation-webui : Une interface utilisateur web Gradio pour de grands modèles linguistiques. Supporte les transferts d'apprentissage et propose des fonctionnalités d'éditeur de texte interactif.

Introduction:

Une interface utilisateur Web Gradio pour de grands modèles linguistiques. Prise en charge des transformateurs, GPTQ, AWQ, EXL2, llama.cpp (GGUF) et les modèles llama. - oobabooga/génération-de-texte-webui

Oobabooga Information sur le produit

Qu'est-ce que Oobabooga ? ?

Une interface utilisateur Web Gradio pour de grands modèles linguistiques. Prise en charge des transformers, GPTQ, AWQ, EXL2, llama.cpp (GGUF), ainsi que les modèles llama.