Oobabooga

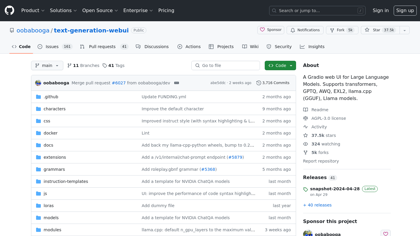

GitHub - oobabooga/text-generation-webui: Uma interface gráfica da web (Gradio) para grandes modelos de linguagem. Suporta a transferência de aprendizado e permite interações com os modelos em tempo real.

Translation:

"GitHub - oobabooga/text-generation-webui: A Gradio web UI for Large Language Models. Supports transfer learning and enables real-time interactions with the models."

Introdução:

Uma interface da web Gradio para grandes modelos de linguagem. Suporta transformadores, GPTQ, AWQ, EXL2, llama.cpp (GGUF), modelos Llama. - oobabooga/geração-de-texto-webinterface

Oobabooga Informação do Produto

O que é Oobabooga? ?

Uma interface da web Gradio para grandes modelos de linguagem. Suporta transformadores, GPTQ, AWQ, EXL2, llama.cpp (GGUF), modelos Llama.