Oobabooga

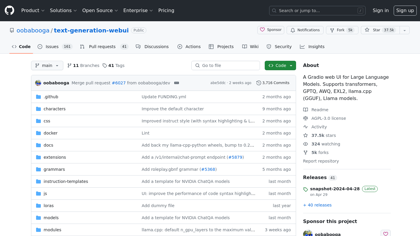

GitHub - oobabooga/text-generation-webui: Un'interfaccia utente web Gradio per grandi modelli linguistici. Supporta il trasferimento

Translation:

GitHub - oobabooga/text-generation-webui: Gradio UI web per grandi modelli di linguaggio. Condivide il trasferimento

Introduzione:

Una interfaccia utente web Gradio per grandi modelli linguistici. Supporta trasformatori, GPTQ, AWQ, EXL2, llama.cpp (GGUF), e modelli llama. - oobabooga/text-generation-webui

Oobabooga Informazioni sul prodotto

Cos'è Oobabooga? ?

Una interfaccia utente web Gradio per grandi modelli linguistici. Supporta trasformatori, GPTQ, AWQ, EXL2, llama.cpp (GGUF), e modelli llama.