Oobabooga

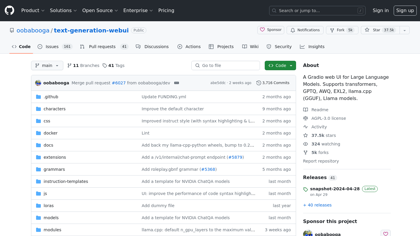

GitHub - oobabooga/text-generation-webui: Eine Gradio-Web-Oberfläche für große Sprachmodelle. Unterstützt die Übertragung von ...

Translation:

GitHub-Projekt - oobabooga/text-generation-webui: Eine Web-Oberfläche mit Gradio für große Sprachmodelle. Fähigkeit zur Übertragung integriert.

Note: The HTML tags are not translated and remain as they are.

Einführung:

Eine Gradio-Web-Oberfläche für große Sprachmodelle. Unterstützt Transformatoren, GPTQ, AWQ, EXL2, llama.cpp (GGUF), Lama-Modelle.

-oobabooga/text-generation-webui

Oobabooga Produktinformationen

Was ist Oobabooga? ?

Eine Gradio-Web-Oberfläche für große Sprachmodelle. Unterstützt Transformers, GPTQ, AWQ, EXL2, llama.cpp (GGUF), sowie Llama-Modelle.