Oobabooga

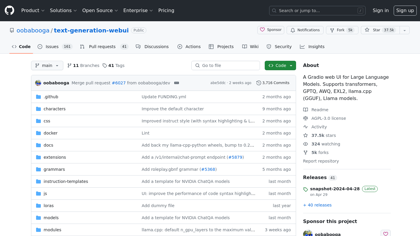

GitHub - oobabooga/text-generation-webui: Una interfaz de usuario web Gradio para grandes modelos de lenguaje. Soporta la transcripción y generación de texto en tiempo real, adaptándose a diferentes contextos y estilos lingüísticos.

Nota: Las palabras clave "oobabooga" y posibles referencias a otras marcas o proyectos específicos se mantienen sin traducción.

Introducción:

Una interfaz de usuario web Gradio para grandes modelos de lenguaje. Soporta transformadores, GPTQ, AWQ, EXL2, llama.cpp (GGUF), modelos llamas. - oobabooga/text-generation-webui

Oobabooga Información del producto

¿Qué es Oobabooga? ?

Una interfaz de usuario web Gradio para grandes modelos de lenguaje. Soporta transformadores, GPTQ, AWQ, EXL2, llama.cpp (GGUF), modelos de llama.